L’Explainable AI (XAI) e l’Interpretable Machine Learning sono due aspetti essenziali nel campo della ricerca e dello sviluppo tecnologico, che avranno importanti ripercussioni nella vita di tutti i giorni e porteranno grandi vantaggi alle aziende che vorranno utilizzare macchine dotate di IA (Intelligenza Artificiale).

Grazie all’Explainable AI (XAI) sarà possibile ottenere due grandi vantaggi:

- produrre dei modelli più chiari che spieghino come opera l’intelligenza artificiale, pur mantenendo un alto livello di prestazioni per le macchine interessate;

- gestire più facilmente la nuova generazione di strumenti e tecnologie dotate di IA, estendendo la comprensione su come funziona il machine learning.

In questa guida spiegheremo nel dettaglio che cos’è la Explainable AI, com’è nata e perché può essere un fattore decisivo per lo sviluppo di un’azienda e il suo successo.

Dall’Artificial Intelligence (AI) fino alla Explainable AI (XAI)

L’intelligenza artificiale cambierà il nostro modo di vivere, gestendo molti dei processi svolti oggi manualmente con nuovi strumenti e tecnologie, che solo pochi decenni fa sembravano appartenere a scenari fantascientifici.

Le più grandi aziende mondiali hanno ormai compreso le potenzialità dell’AI (Artificial Intelligence) e stanno investendo ingenti risorse economiche e umane per lo sviluppo di sistemi “intelligenti”, che siano in grado di rivoluzionare il loro business.

Come mai allora alcune imprese si mostrano dubbiose rispetto all’impatto e ai rischi dell’introduzione di sistemi di AI nelle logiche aziendali?

Questo atteggiamento deriva da diversi fattori che vanno dalla mancanza di competenze interne specializzate, alla percezione distorta delle potenzialità di queste tecniche, fino alla paura di delegare a una black-box decisioni importanti per l’azienda.

Anche per far fronte a quest’ultimo problema, negli ultimi anni, molti ricercatori hanno sviluppato nuovi strumenti con l’obiettivo sia di fornire delle alternative ai sistemi black box, sia di progettare metodi per l’analisi a posteriori degli algoritmi esistenti.

È nata così una nuova area di ricerca, detta Explainable Artificial Intelligence (XAI), che studia e progetta algoritmi le cui scelte sono comprensibili dagli esseri umani e descrivibili da relazioni causa-effetto.

Interpretability e Explainability nel Machine Learning

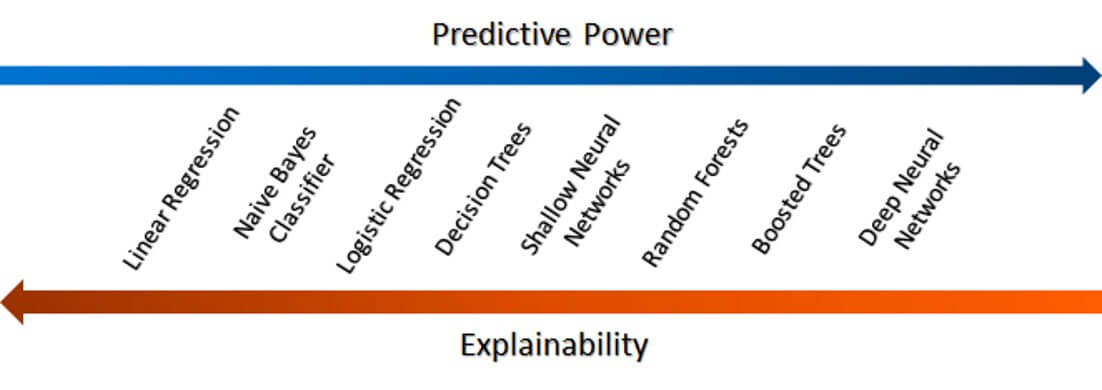

Un primo step per rendere più comprensibile il funzionamento di un sistema di Intelligenza Artificiale è quello di adottare modelli intrinsecamente interpretabili. L’Interpretability di un modello nel Machine Learning è definita come il grado con cui un umano può predirne regolarmente il risultato.

Nella pratica quando adottiamo un modello interpretabile l’utilizzatore umano può avere una maggiore consapevolezza di come il modello si comporterebbe se ricevesse un determinato input. Se si costruisce un modello di Explainable AI si può ottenere un grande vantaggio: consentire un ulteriore livello di comprensione del sistema.

Con Explainability, infatti, si intende la possibilità di comprendere e quantificare le relazioni causa-effetto che portano a un output e di estrar particolari informazioni colte dal modello.

In sintesi, se l’Interpretability ci permette di capire come il modello arriva a un determinato output (How), l’Explainability ci consente anche di coglierne le motivazioni più profonde (Why).

Perché si usa l’Explainable AI?

L’explainability conferisce ai sistemi di AI diverse proprietà che impattano in modo significativo su diversi aspetti, e che li rendono preferibili alle black box per la gestione dei processi più critici:

- Conoscenza. I modelli explainable consentono di estrarre preziose informazioni dai dati fornendo una rappresentazione delle relazioni causa/effetto tra le variabili in gioco che normalmente sfuggono all’uomo;

- Fiducia. Le decisioni prese da un modello explainable sono più facilmente accolte dagli operatori umani in quanto il processo che le ha generate è trasparente;

- Robustezza. Tipicamente i modelli explainable sono anche robusti, ovvero piccole variazioni dell’input non si traducono in variazioni drastiche dell’output;

- Sicurezza. Nei modelli explainable, l’essere umano può intervenire nella definizione dei meccanismi che portano alla generazione dell’output evitando che il modello prenda decisioni troppo rischiose o addirittura catastrofiche;

- Fairness. L’adozione di questi modelli ci consente di essere sicuri che non è presente un bias nei dati.

Blackbox vs Glassbox: le differenze

Grazie alla loro trasparenza, i sistemi basati su Explainable AI sono stati definiti glassbox, in contrapposizione alle blackbox, le cui scelte risultano “incomprensibili” agli utilizzatori.

Ovviamente l’altra faccia della medaglia della complessità dei modelli black box è una maggiore espressività, che consente loro di risolvere task molto difficili e descrivere processi molto complessi, anche se questo non è un dato scontato: non è raro, infatti, che in molti contesti i sistemi basati su Explainable AI raggiungano performance paragonabili a quelle dei sistemi blackbox.

In sintesi, la scelta tra blackbox e glassbox va valutata attentamente da esperti che sappiano tenere conto sia dei requisiti che l’utilizzatore vuole soddisfare (vedi sopra), sia della natura del problema che si vuole risolvere.

Un esempio di Explainable AI: auto a guida autonoma

Le auto a guida autonoma sono un problema la cui risoluzione presenta un alto grado di complessità, su cui sia le grandi aziende che la comunità scientifica stanno investendo molto.

La difficoltà nell’implementare sistemi di AI capaci di eseguire questo task è dovuta a diversi fattori:

- in primo luogo, un veicolo autonomo deve eseguire simultaneamente molteplici sub-tasks a diversi livelli di astrazione;

- nel contempo l’apprendimento di questi task richiede un processo di apprendimento che necessita di una elevata mole di dati che siano in grado di descrivere molti scenari di guida.

- infine, il comportamento di un veicolo autonomo deve privilegiare azioni sicure che non mettano a rischio il passeggero, tuttavia non è banale fornire in fase di training tutti gli scenari necessari a descrivere la giusta policy da adottare in situazioni rischiose.

Per questo motivo, per i task di alto livello, l’adozione di approcci basati sulla Explainable AI può essere la giusta soluzione per rendere l’output del sistema prevedibile e quindi più sicuro: le tecniche di XAI atte ad analizzare il comportamento di metodi esistenti sono in grado di valutare il comportamento del sistema sviluppato, a seconda al variare dei parametri in ingresso al sistema.

Ad esempio, un sistema che basi il suo comportamento di frenata in base alla temperatura atmosferica potrebbe fallire in condizioni estreme, a causa del fatto che tali condizioni non siano presenti nei dati utilizzati per addestrare il sistema.

Le tecniche di XAI, invece, permettono di valutare quale sia l’impatto di temperature anormali sul funzionamento del sistema.

Per saperne di più:

- Christoph Molnar Interpretable Machine Learning, A Guide for Making Black Box Models Explainable (2020)

- Miller, Tim. “Explanation in artificial intelligence: Insights from the social sciences.” Artificial Intelligence 267 (2019): 1-38.

- Murdoch, W. James, et al. “Interpretable machine learning: definitions, methods, and applications.” arXiv preprint arXiv:1901.04592 (2019).